|

У поисковика

существует три основных источника

информации для вычисления

релевантности страницы: содержание

страницы и сайта, другие web-сайты и

поведение пользователей. Первым

источником легко манипулировать,

второй поддается только

ограниченному воздействию, влиять же

на третий крайне сложно. Поэтому

поисковики придают большой вес

последним двум источникам.

Оптимизируя сайты, всегда

проговаривайте про себя вопрос: «Как

поисковик будет действовать в момент

запроса?». Очень часто это помогает

найти новые решения. Приведем простой

пример: когда пользователь задает

слово запроса строчными буквами, «Яндекс»

находит все вхождения слова,

независимо от его регистра; но если

слово написано с прописной буквы, «Яндекс»

будет искать только такие варианты.

Следовательно, начиная с прописной

буквы в тексте страницы все слова,

которые пользователь часто пишет с

большой буквы, вы повышаете

вероятность нахождения страницы по

всем видам данного запроса.

Содержание

страницы и сайта

Текст

страницы

Поисковик

интересуется, прежде всего, тем,

насколько часто встречается слово из

запроса в документе по сравнению с

другими

словами. Если

слов в запросе несколько, то вес

каждого из них тем больше, чем в

меньшем количестве документов базы

оно содержится. В то же время страница

со слишком часто встречающимся словом

запроса считается спамом, и ее позиция

в результатах поиска заметно

понижается. Каким образом следует

выбирать ключевые слова для

оптимизации? Во-первых, чем чаще их

запрашивают, тем лучше. Во-вторых, чем

меньше конкурирующих сайтов, тем

легче добиться хорошей позиции. В-третьих,

так как вес слова тем больше, чем реже

встречается оно в других документах,

то при оптимизации под запросы из

нескольких слов выгодно делать упор

на редкие слова.

Тэги и

метатэги

Откуда пошли

мифы про чудодейственную силу

метатэгов? Из истории поисковиков.

Когда поисковики были маленькими, а web-мастера

неопытными, кто-то подумал: «А зачем

городить эти сложные алгоритмы

вычисления релевантности, если можно

попросить web-мастеров описать словами

в специальных тэгах их сайт? Уж

человек-то наверняка разбирается в

том, какие темы его сайт охватывает!»

Возможно, первое время так и было. Web-мастеры

скромно писали в метатэгах «личная

страничка, Вася, Пупкин, кошка Люся» и

были счастливы, видя свой сайт вверху

результатов поиска по запросу «кошка

Васи Пупкина». Но прошло время, web-мастеры

узнали, что такое баннер и как его

можно продать, и началось: «рефераты,

рефераты, рефераты». Наивные

поисковики стали находить по слову «рефераты»

все, что им предлагали. В итоге,

сегодня «Рамблер» не учитывает

метатэги совсем, «Яндекс» — только

если соответствующие им слова часто

встречаются в тексте страницы, а «Апорт»

лишь незначительно поднимает вес

страницы при совпадении запроса со

словом из метатэга. Alt-тэги

изображений учитывают далеко не все

поисковики, но некоторые к ним

внимательно прислушиваются, так что

забывать о них не стоит. Тем не менее

есть один особенно важный тэг — это

тэг <title> заголовка страницы. В

отличие от метатэгов, пользователь

видит его на экране, поэтому поисковик

придает <title> большое значение. Что

нужно делать с тэгами? Даже если

метатэги влияют на один поисковик из

десяти, поставить их стоит — это дело

одной минуты. Выберите самые

популярные слова со страницы, которые

совпадают с ключевыми, и внесите их в

метатэги. В <title> желательно из этих

слов составить нормальный заголовок.

Положение

слов на странице

Когда на запрос

«свободная экономическая зона»

находятся тексты о переполнении зон

из-за экономической ситуации, это

значит, что поисковик не учитывает

близость слов в

тексте. Это плохой поисковик.

Большинство современных искалок

отдают приоритет совпадению фраз и

стараются найти документы, где слова

стоят как можно ближе друг к другу.

Многие поисковики учитывают

расстояние от начала страницы до

слова, считая, что в начале чаще

располагается важная информация.

Как

оптимизировать страницу с учетом этих

данных? Во-первых, при оптимизации под

запрос из нескольких слов

соответствующие слова в тексте нужно

располагать как можно ближе друг к

другу. Во-вторых, начинайте страницу с

самых важных слов.

Оформление

Когда страница

встречает заголовком с буквами таких

размеров, что возникают сомнения,

поместится ли здесь что-то еще, можно

предположить, что информация в таком

заголовке очень важная. Поэтому

поисковик придает дополнительный вес

словам, расположенным в заголовках

(<hl>...<h6>), тэгах <strong>, <em>,

<b>, <i> и др. Как же это

использовать? Во-первых, надо как

можно чаще использовать эти тэги для

важных слов. Во-вторых, если вспомнить

о CSS (каскадные таблицы стилей), то

обнаружится, что многие поисковики не

интерпретируют информацию CSS, и даже

когда половина текста будет набрана

заголовком <hl>, переопределив вид

тэгов в CSS, можно получить красивый и

опрятный дизайн.

Сайт в

целом

Представьте

себе переборчивого жениха, который

никак не может отыскать невесту с

нужными характеристиками, скажем,

интеллигентную. Вот эта, кажется,

подходит, но родители у нее землекопы;

а вон та, похоже, интеллигентная, но,

беря пример с брата-уголовника и отца-депутата,

она, думает парень, вряд ли останется

такой. Тогда жених определяет для себя:

если все родственники у невесты, как и

она сама, интеллигентны, значит

подходит. Примерно так же рассуждает

поисковик, когда дает приоритет тем

сайтам, на которых больше число

страниц, соответствующих запросу. В

чем-то это верно, когда речь идет про

интеллигентность, но если нужно

выбрать невесту с длинными волосами,

то коротко остриженные родственники,

на мой взгляд, не должны быть помехой.

Как лучше в этом

случае оптимизировать сайт? Чем

больше страниц на сайте, включающих

слова запроса, тем больше вес каждой

из них. Следовательно, число страниц

должно быть как можно больше. Этот

совет имеет еще два плюса: во-первых,

при грамотном использовании ссылок

можно существенно увеличить вес сайта

по алгоритму PageRank, во-вторых,

возрастает вероятность случайного

захода на страницу. Для умеренно

популярной темы тысяча русскоязычных

страниц безо всякой оптимизации

приносят до

40-70 случайных

посетителей с каждого поисковика,

который проиндексировал сайт.

Тема

сайта

Некоторые

поисковики стараются определить тему

сайта, и, если она не совпадает с темой

запроса, то такой сайт даже не

рассматривается. Как избежать этого?

Алгоритмы, определяющие тему сайта,

как правило, исследуют слова,

присутствующие на странице, сравнивая

их со словами, часто встречающимися

для данной темы. Следовательно, если

изучить частоту слов из десятка

текстов на интересующую вас тему и

удостовериться, что все самые

популярные слова есть на страницах

сайта, то с темой будет полный порядок.

Хижина

дяди Сэма

Есть вещи,

которые покупаются редко или раз и

навсегда: дом, неподкупный политик,

домен для сайта. Логично предполагать,

что покупатель не пожелает себе

плохого, а постарается, чтобы

приобретение соответствовало его

вкусам и роду деятельности.

Основываясь на этой догадке,

поисковики придают дополнительный

вес страницам, у которых домен или имя

файла совпадают с ключевым словом (что

возможно только для англоязычного

поиска). У многих искалок есть еще одно

предпочтение — некоммерческие домены

первого уровня (вроде edu и gov) и домен com.

И что же делать?

Домен не так важен, как кажется:

достаточно взглянуть на результаты

поиска, чтобы убедиться, что доменов,

совпадающих с запросом, в первой

десятке довольно мало. В то же время,

когда можно задать имя файла,

совпадающее с ключевым словом, не

стоит игнорировать эту возможность.

Другие

web-сайты

Ссылочное

ранжирование

Когда на сайт

ссылаются десятки страниц словами «а

эти козлы не вернули мне деньги», это,

как правило, означает, что по ссылке

действительно можно найти козлов.

Правда, этот же сайт будет находиться

и по слову «деньги», что, в принципе,

тоже верно, потому что деньги остались

у козлов. Так вот, это и называется

ссылочным ранжированием. Написать на

своей странице можно что угодно, но

когда на нее все ссылаются теми же

словами, поисковик начинает доверять.

Что тут делать? До того, как начнете

регистрироваться в каталогах и

обмениваться ссылками, выберите

краткое название своего сайта,

включающее слова, под которые он

оптимизируется. Тогда с большой

вероятностью ссылка будет выглядеть

так, как вам хочется. Несмотря на

простоту, алгоритм имеет огромное

значение при вычислении

релевантности, и ему нужно уделять

самое пристальное внимание.

Присутствие

в каталоге

Многие

поисковики имеют при себе каталоги.

Как они используют их? Во-первых, сайт

поднимается в результатах, если слова

запроса совпадают с описанием из

каталога. В некоторых искалках

дополнительный вес сайту дает сам

факт присутствия в каталоге, так как в

него попадают ссылки только на

качественные страницы. Во-вторых, если

сайт отсутствует в каталоге, а

пользователь ограничивает поиск

какой-то темой (такое позволяет «Яндекс»),

то даже при совпадении с темой сайта

он показан не будет.

И наконец, стоит

помнить о том, что однословные запросы

обычно выполняют роль навигационных (пользователь

хочет не найти какой-то факт, а

получить «что-то на эту тему»). И тут

как нельзя лучше подходят сайты из

соответствующей категории каталога.

Посмотрите на выдачу «Яндекса» по

популярным однословным запросам:

сплошь главные страницы сайтов и

сайты из каталога.

Как можно это

использовать? А что тут думать,

регистрируйтесь!

Пользовательская

оценка

В мире

поисковых алгоритмов существует

система DirectHit. Ее идея оценки качества

сайтов основана на предположении, что

если пользователь переходит по ссылке,

значит, он счел ее хорошей, и если

долго не возвращается на страницу

поисковика, значит, его ожидания

подтвердились. Именно эти критерии —

число переходов по ссылке, время

нахождения на странице и возвраты к

поисковику — легли в основу

корректора релевантности, который

DirectHit предлагает другим сайтам.

«Рамблер» до

пяти первых сайтов в результатах

поиска берет из рейтинга «Тор 100» (а

посещаемость — своего рода

пользовательская оценка). У «Яндекса»

есть «Популярные находки» — раздел, в

котором отображаются сайты с

относительно небольшой

релевантностью, но часто выбираемые

пользователями.

И что, совсем-совсем

нельзя повлиять на это? Повлиять можно.

Представьте, на основе каких

критериев пользователи решают

перейти на сайт. Заголовок — раз.

Описание — два. URL — три. Заголовки

должны учитывать психологию

восприятия (см.

http://ad-market.boom.ru/read/ogiLvy.html). Что касается

описаний, то поисковики берут их из

метатэга description или выдергивают из

текста страницы отрывки со словами

запроса. Позаботьтесь, чтобы такие

отрывки привлекали внимание.

Любые ухищрения

на тему популярности в результатах

поиска не дадут результатов до тех пор,

пока поисковый робот не зайдет на сайт

и поместит его содержимое в индекс

поисковой базы. Существует несколько

способов провести индексацию своего

ресурса. Наиболее простой, но наименее

эффективный, — это просто добавить

адрес сайта в соответствующую форму

поисковой машины. Но при этом

пришествия робота можно ожидать очень

и очень долго (особенно в случаях с

западными поисковиками). С другой

стороны, если ваш сайт будет найден по

ссылке с популярного ресурса, это не

только приведет к мгновенной

индексации, но и существенно повысит

рейтинг страниц сайта в глазах

поисковика.

Однако зачастую

не меньшей проблемой является процесс

переиндексации сайта. Для людей,

занимающихся экспериментами по

выведению идеального HTML-кода, это

необходимое условие, да и вообще

всегда полезно, чтобы робот время от

времени посещал сайт и заносил новые

страницы в свой индекс.

Как ускорить

переиндексацию? Есть несколько

способов, ни один из которых не дает

стопроцентной гарантии: Поднять вес

страницы. Google и другие поисковики,

использующие алгоритм РаgeRank,

индексируют новые страницы в порядке

убывания их веса, а страницы с большим

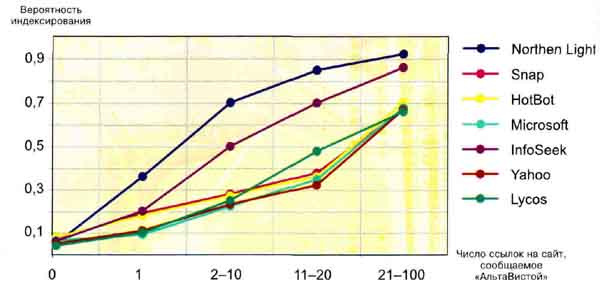

весом чаще переиндексируют. Страницы

с малым числом ссылающихся на них

сайтов имеют мизерные шансы на

переиндексацию (рис. 2). Обновлять сайт

регулярно, поскольку поисковики

стараются определить период

обновления сайта, чтобы не приходить

слишком часто.

Заплатить

деньги. Например, Inktomi обещает после

оплаты переиндексировать сайт каждые

48 часов в течение года. Если сайт

относится к СМИ, можно

зарегистрировать его как новостное

агентство. Сайты новостных агентств переиндексируются

очень часто («Яндексом» — каждые 15

минут).

Переименовать

страницы, которые нужно срочно

переиндексировать и добавить заново в

поисковик, а старые удалить.

Рис. 2.

Число ссылок на сайт

Работает только

в тех случаях, когда поисковик

индексирует быстро и имеет

возможность удаления старых страниц (например,

«Яндекс», Google).

Можно ли,

поставив эксперимент, узнать алгоритм

поисковика или его часть? Конечно!

Метод

деления пополам

Допустим, вас

заинтересовал какой-либо показатель,

влияющий на релевантность страницы, и

вы предполагаете, что у него есть

оптимум — меньшее значение делает

страницу менее релевантной, а большее

уже рассматривается как спам. Условно

будем считать таким показателем

процент ключевых слов на странице.

Для

эксперимента создаются три страницы,

в одной из которых процент ключевых

слов близок к нулю, во второй таков,

что гарантированно будет сочтен

спамом, а третья находится ровно

посередине. Регистрируем и ждем

индексации страниц. В зависимости

оттого, первая или вторая страница

оказалась более релевантной, отсекаем

половину исследуемого диапазона

сверху или снизу. Повторяем до тех пор,

пока оптимум не найден с нужной

точностью.

Недостатков у

метода всего два, но очень больших. Во-первых,

никто не говорил про простои и

линейный характер зависимости. Во-вторых,

метод требует многократной

переиндексации страницы, что обычно

слишком долго, да и алгоритм

поисковика тем временем может

измениться. Как избежать недостатков?

Метод

дроби

Зная, как и в

предыдущем случае, примерный диапазон

изменения процента ключевых слов,

можно сделать не одну страницу, а 10-20,

где процент ключевых слов изменяется

с шагом, например, в 1%. Когда среди них

станут известны две-три наиболее

релевантные страницы, чтобы точнее

выяснить оптимальный процент

ключевых слов, можно будет добавить

еще 10-20 страниц с шагом исследуемого

показателя в 0,1%. Когда поисковики их

зарегистрируют, в любой момент,

взглянув на их положение в

результатах, можно будет сказать,

какой процент ключевых слов на данный

момент оптимален. Недостаток,

касающийся сложного характера

зависимости, остался. Что же делать с

ним?

Аналитические

методы

В случаях, когда

характер зависимости не ясен даже

примерно, либо на исследуемые

показатели нет возможности влиять,

следует изучать зависимости на основе

чужих сайтов. В такой ситуации резко

возрастает

влияние

посторонних факторов и шумов, поэтому

появляется необходимость

использовать методы

интеллектуального анализа данных (data

mining, статистические пакеты и др.).

Учитывая

сложность получения данных (например,

веса страницы по алгоритму РаgeRank), на

первом этапе сбор информации может

касаться относительно небольшого

числа страниц и запросов (десятки), для

которых будет собрано максимальное

число показателей, известных вам.

После предварительного анализа

информации можно выделить показатели,

наиболее сильно связанные с

интересующим вас параметром, и затем

собирать данные только о них.

Аналитические

методы получили большую популярность,

что доказывают многочисленные

попытки реализовать их программно, о

которых мы расскажем далее.

Источник: журнал CHIP

01/2002г.

|